Ein Chatbot sollte nicht zu cool sein

Alfred Benedikt Brendel ist Professor für Wirtschaftsinformatik an der Technischen Universität Dresden. Sein Lehrstuhl befasst sich mit der Gestaltung von Mensch-Maschine-Interaktionen, Schwerpunkte der Forschung sind intelligente Mobilität, digitale Gesundheit und die Zukunft der Arbeit. Er untersucht unter anderem gemeinsam mit einem Neurobiologen, was die Konversation mit Chatbots und Conversational Interfaces im Gehirn auslöst, also zum Beispiel wie viel Stress Menschen dabei empfinden. Wir haben uns mit Prof. Brendel über gruselige Begegnungen und die Grenzen von automatisierter Interaktion unterhalten.

Interview: Una Sprenger & Maria Gerono • 15.04.2021

betterHR: Was sind deiner Ansicht nach aktuell die größten Herausforderungen im Chatbot Design?

A. B. Brendel: Das KIT (Karlsruher Institute of Technology) hat dazu eine Studie herausgebracht, die aktuell ein paar Wellen schlägt. Dazu haben sie sich Chatbots in der Praxis angesehen und herausgefunden, dass Chatbot Designer jede Menge Annahmen im Kopf haben, die gar nicht überprüft sind. Wenn ich mich richtig erinnere, dann waren ca. 70 % der Chatbots weiblich, unabhängig vom Kontext und ohne, dass es hinterfragt wurde. In der Literatur haben wir uns mit dem Thema schon beschäftigt und wissen, ein männlicher Chatbot wirkt meist kompetenter, ein weiblicher wirkt meist freundlicher, obwohl sie genau dieselben Sätze sagen. In der Industrie werden solche Entscheidungen aktuell noch getroffen, ohne sie zu reflektieren, ohne zu wissen, was sie auslösen. Eine ganz zentrale Herausforderung ist das Self-Disclosure Dilemma.

betterHR: Was genau ist darunter zu verstehen?

A. B. Brendel: Wenn ein Chatbot klar zu erkennen gibt, dass er eine Maschine ist und kein Mensch, dann wird er anders wahrgenommen. Das ist ein Problem, obwohl es ethisch korrekter ist. Ich meine es gibt mittlerweile sogar rechtliche Bestrebungen, das regulatorisch abzudecken, damit Nutzende sofort wissen, womit sie es zu tun haben.

Wenn wir nicht klar zu erkennen geben, dass es sich um eine Maschine handelt, manipulieren wir ja in gewisser Weise.

Studien haben gezeigt, wenn der Chatbot sagt, “damit kann ich nicht weiterarbeiten, ich gebe mal an einen Menschen weiter”, dann geben die Nutzer plötzlich längere Antworten, sind konzentrierter und auch freundlicher, weil sie wissen, jetzt sprechen sie mit einem Menschen. Und diesen Effekt wünscht man sich ja auch mit einem Chatbot. Man möchte, dass der Nutzer sich wohlfühlt, sich aber auch Mühe gibt um eine gute Interaktion zu erzielen. Führt nun die volle Transparenz zu mehr Vertrauen, wenn also der Nutzer weiß, dass er es mit einer Maschine zu tun hat, die besonders menschlich gestaltet wurde, um Vertrauen zu schaffen? Oder hat das eher den umgekehrten Effekt und der Nutzer ist besonders skeptisch und vorsichtig?

betterHR: Skepsis oder sogar Unwohlsein entsteht ja grundsätzlich, wenn Roboter oder Chatbots zu sehr menschliche Züge annehmen.

A. B. Brendel: Genau, man spricht hier vom Uncanny Valley Effekt. Plötzlich wird der Chatbot ganz schlecht wahrgenommen, obwohl man eigentlich nur Verbesserungen eingebaut hat, um ihn noch menschlicher wirken zu lassen. Ein Beispiel dafür ist, was wir als das “Cringe Valley” bezeichnen.

Ab einem gewissen Punkt haben insbesondere junge Leute das Gefühl, der Chatbot biedert sich zu sehr an.

Er benutzt Memes und GIFs und Jugendsprache und man hat das Gefühl, jetzt wird es ganz gruselig. Wir starten gerade einen Versuch, in dem der Chatbot solche Elemente verwendet und wollen uns anschauen, wie das ankommt. Wie gehen männliche, weibliche, diverse, ältere und jüngere Nutzende damit um? Sollte ein Chatbot cool sein? Wo kippt das Ganze?

Außerdem beschäftigen wir uns damit, inwieweit ein Chatbot im Bereich Gamification eingesetzt werden kann. Hier werden ja Spielelemente im Arbeitskontext genutzt. Man bekommt also zum Beispiel ein Badge für besondere Leistungen, oder steigt im Ranking höher, wenn man bestimmte Aufgaben erfüllt hat. Das steigert die Motivation und fördert die Leistung. In diesem Kontext haben wir einen Chatbot eingesetzt, der diese Dinge abdeckt und sagt, “Das war super! Mach weiter! Du schaffst das!”. Das wird total schlecht angenommen, das fanden die Leute befremdlich.

betterHR: Unserer Erfahrung nach kann es auch ganz klar ein Problem darstellen, die Grenze zwischen Mensch und Maschine nicht transparent zu ziehen und es ist für die Nutzenden am einfachsten, einen Chatbot zu verwenden, wenn sie genau verstehen, wie er funktioniert. Also was kann ich erwarten, wie verhalte ich mich, um das beste Ergebnis zu erzielen? Ähnlich wie bei einer Google Suche oder der Nutzung von Social Media.

A. B. Brendel: Das Ganze muss man von zwei Seiten betrachten. Wo genau liegt der Mehrwert eines Chatbots? Geht es um die nette Interaktion, die ich mit einem Chatbot habe, obwohl ich eigentlich auch einfach selber ein Formular ausfüllen könnte? Das macht Spaß und motiviert mich, dranzubleiben. Oder handelt es sich um ein so komplexes System aus Daten und Algorithmen, das ich als Nutzer allein nicht durchdringen kann, so dass ich einen Chatbot brauche, der mich da durch navigiert? Dann ist es ganz wichtig, dem Nutzer so eine Chatbot Literacy mitzugeben, die verdeutlicht, dass er nicht zum Plaudern da ist, sondern dabei unterstützt, effizient durch die verschiedenen Datensätze zu manövrieren, ganz ohne Floskeln und Emojis.

Je mehr Erfahrung Menschen mit Chatbots haben, umso weniger funktionieren diese pleasant elements, also Emojis oder Geplauder.

Denn der Nutzer weiß hinter dieser Fassade stecken Regeln und Logiken und nicht jemand, der sich freut, dass das Wetter heute gut ist. Das ist der schmale Grat, auf dem man sich da bewegt. Ich glaube, es ist ganz wichtig zu differenzieren, warum man einen Chatbot einsetzt. Geht es um das Vereinfachen von Interfaces oder die beschriebene Vermenschlichung, die positive Emotionen auslösen soll?

betterHR: Muss ein Chatbot denn so menschlich wie möglich sein oder hat er nicht ohnehin eine eigene Daseinsberechtigung, weil er über Qualitäten verfügt, die über menschliche Fähigkeiten hinausgehen?

A. B. Brendel: Jein. Wir Menschen haben diesen Anthropomorphismus Bias ganz tief in uns einprogrammiert. Das ist das erste, was ein Baby macht, es sucht das Gesicht der Mutter. Es sieht zwar noch alles verschwommen, aber es wird sofort erkannt. In der physischen Welt spricht man dann vom Pareidolie-Effekt, wenn man zum Beispiel das Gefühl hat, der BMW sieht aggressiv aus und der Beetle freundlich. Das sind beides Maschinen, aber unser Gehirn projiziert menschliche Züge auf die Fronten der Autos. Ähnliches passiert, wenn wir der Katze auf dem Fensterbrett unterstellen, dass sie gerade verträumt über etwas nachdenkt.

Diese Identifikation von menschlichen Mustern in der Welt sorgt dafür, dass wir uns wohlfühlen. Und das spielt auch in der Chatbot Entwicklung eine Rolle.

Fühlen sich Leute noch wohl, wenn ich diesen Anthropomorphismus Bias nicht aktiv anspreche? Hier kommt es sehr stark auf den Nutzer und auf den Nutzungskontext an. Wollen meine Nutzer noch so eine gewisse Menschlichkeit? Wenn ja, wie viel?

betterHR: L�öst nicht gerade ein zu sehr vermenschlichter Chatbot oder Roboter Beklemmungen aus?

A. B. Brendel: Das kann ganz klar passieren. Wenn ich zum Beispiel an den Hanson Roboter Sophia denke, die finde ich total unheimlich. Sie hat ganz menschliche Lippen und Zähne, das Gesicht ist sehr naturalistisch, sie hat aber so einen Glashinterkopf. Das finde ich persönlich sehr unangenehm.

Ein Gegenbeispiel ist Wall-E aus dem Disney Film. Der hat nur Arme und ein paar angedeutete Augen und ist irgendwie total süß und knuffig, obwohl er viel mehr Roboter ist als Sophia. Da muss man sich wieder die Frage stellen: Was sind die Erwartungen meiner Nutzer? Das macht das Thema so unheimlich komplex und aus wissenschaftlicher Sicht so spannend, denn wir sind als Menschen jahrelang darauf trainiert und auch genetisch programmiert, sozial zu interagieren. Aber wenn man dieses implizite Verständnis explizit machen will, machen wir plötzlich schlimme Fehler.

Wir haben zum Beispiel auch schon Feedback bekommen, dass so ein Zwinkersmiley, den wir eingesetzt haben, an manchen Stellen als total unangenehm empfunden wurde, oder dass die Nutzer vom Chatbot nicht einfach geduzt werden wollen.

betterHR: Häufig werden Chatbots ja völlig aus dem Blauen heraus mit Fragen bombardiert, nur um zu testen, wie sie reagieren. Habt ihr damit Erfahrungen gemacht?

A. B. Brendel: Wir haben mal ein Experiment durchgeführt, bei dem wir herausfinden wollten, warum Menschen Chatbots beleidigen. Dafür haben wir Tests mit Studierenden und Crowdworkern durchgeführt. Die Studierenden haben unseren Chatbot aufs Schlimmste beleidigt, das kann ich hier gar nicht wiedergeben. Die Crowdworker hingegen haben das überhaupt nicht gemacht. Der Arbeitskontext, in dem sie mit dem Chatbot interagiert haben, hat sie davon abgehalten.

Da wird sehr schnell klar, dass menschliche Interaktion hochkomplex ist und man muss sehr vorsichtig sein, hier das richtige Fahrwasser zu finden und verallgemeinernde Gesetzmäßigkeiten abzuleiten.

betterHR: Wenn du dir die aktuellen Use Cases für Chatbots anschaust, wo hast du das Gefühl, funktioniert das schon sehr solide?

A. B. Brendel: Im Vertragswesen funktioniert das schon sehr gut, wenn also dahinter einfach ein sehr standardisiertes Formular steht. Wenn ich zum Beispiel einen Vertrag abschließen oder kündigen will oder ein Ticket buchen.

Es funktioniert gut, wenn die menschliche Interaktion ohnehin sehr limitiert ist. So etwas können Chatbots schon super, weil der Trampelpfad klar ist.

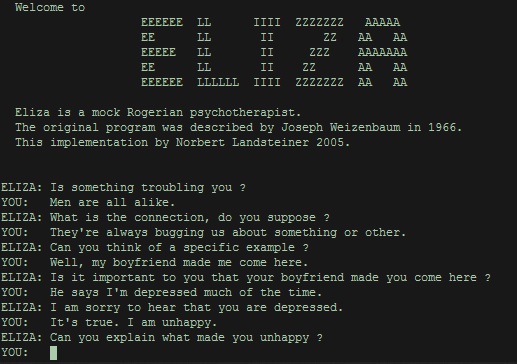

Ich glaube, im Gesundheitsbereich entwickelt es sich gerade in die richtige Richtung. Da gibt es mittlerweile viele Assistenten, die bei Medikamenteneinnahme, Rauchentwöhnung oder Stressbewältigung unterstützen. Einer der ersten Chatbots wurde ja von Psychologen entwickelt. Es stellte sich heraus, dass die Sekretärin sehr gern mit diesem Chatbot (ELIZA, Anm. d. Red.) interagiert hat, weil sie den so nett fand. Da wurde zum ersten Mal klar, dass Chatbots viel mehr können, als nur Nutzererlebnisse vereinfachen.

betterHR: Wo siehst du eher Begrenzungen?

A. B. Brendel: Wir diskutieren in der Wissenschaft gerade die Nutzung im Team Setting, also Chatbots als Teampartner oder Koordinator. Das klappt meiner Meinung nach noch nicht so richtig. Also wenn zum Beispiel bei Slack ein Chatbot versucht, Teil des Teams zu sein. Der macht vielleicht ein paar nette Sachen, aber wenn man wirklich einen Kreativ-Workshop oder ein Teammeeting von einem Chatbot abhalten lassen möchte, dann klappt das einfach noch nicht.

Wenn also viele verschiedene Befindlichkeiten, Menschen und komplexe Situationen zusammenkommen, die vielleicht auch zwischenmenschlich etwas tricky sind, dann wird es schwierig.

Hier haben wir auch Experimente durchgeführt zur Sentiment Analyse, wo es darum geht, die Emotionen des Nutzenden erkennen. “Ja” kann man zum Beispiel auf sehr viele unterschiedliche Arten sagen: “Ja”, “Jawoll” oder auch “Wenn du das sagst”. Letzteres bedeutet zwar auf der Informationsebene “Ja”, aber der Sender ist offenbar gerade nicht so gut drauf und irgendwie sarkastisch. Da muss man schon sehr viel investieren, damit der Chatbot da auch nur einigermaßen hinterherkommt. Je komplexer die soziale Interaktion wird, je mehr soziale Akteure beteiligt sind und je wichtiger es ist, dass alle sich abgeholt fühlen, um so schwieriger wird es für einen Chatbot.

betterHR: Vielen Dank für das Gespräch!

Photo Credit: geralt; Wikimedia Commons